當(dāng)您使用 GPU 進(jìn)行模型推理時(shí),您希望獲得盡可能高的性價(jià)比。了解利用率是關(guān)鍵——高 GPU 利用率意味著需要更少的 GPU 來(lái)處理高流量工作負(fù)載。您可以使用一些手段來(lái)提高利用率,例如更大的批量大小和針對(duì)服務(wù)優(yōu)化的模型引擎。您可以在工作區(qū)中每個(gè)模型的“指標(biāo)”選項(xiàng)卡中衡量這些更改的影響。

GPU 利用率衡量的是工作負(fù)載期間 GPU 資源的使用量。在運(yùn)行 ML 模型時(shí),我們希望最大限度地提高 GPU 利用率,以降低服務(wù)高流量模型端點(diǎn)的成本。如果每個(gè) GPU 的性能更高,則能夠使用更少的 GPU 來(lái)處理相同的流量,從而節(jié)省模型托管成本。

想象一下,你和整個(gè)團(tuán)隊(duì)(假設(shè)有 12 個(gè)人)在辦公室。你們都需要去參加城鎮(zhèn)另一邊的活動(dòng),所以你們預(yù)訂了幾輛 Uber。如果每輛車坐 4 個(gè)人,你只需要叫 3 輛車。但如果每輛車只有 2 或 3 個(gè)人,你就需要更多車了——可能會(huì)花費(fèi)兩倍的錢(qián)。

就像這個(gè)拼車比喻只有在人數(shù)眾多的情況下才有意義一樣,GPU 利用率在高流量工作負(fù)載下變得非常重要。當(dāng)您為模型處理如此多的請(qǐng)求時(shí),您必須啟動(dòng)額外的實(shí)例來(lái)處理負(fù)載,您需要確保您支付的每個(gè)實(shí)例都在做盡可能多的工作。

一、如何測(cè)量 GPU 利用率

對(duì)于 GPU 利用率,有三個(gè)主要統(tǒng)計(jì)數(shù)據(jù)需要考慮:

計(jì)算使用情況:GPU 運(yùn)行內(nèi)核的時(shí)間百分比是多少,空閑的時(shí)間百分比是多少?

內(nèi)存使用情況:推理期間有多少 GPU 的 VRAM 處于活動(dòng)狀態(tài)?

內(nèi)存帶寬使用情況:有多少可用帶寬用于將數(shù)據(jù)發(fā)送到計(jì)算核心?

當(dāng)我們談?wù)撎岣?LLM 的 GPU 利用率時(shí),我們幾乎總是指增加計(jì)算使用率。這是因?yàn)閮?nèi)存帶寬通常是推理速度的瓶頸,而計(jì)算能力可能會(huì)被擱置。雖然總體 VRAM 容量限制了模型大小和并發(fā)提示的數(shù)量,但它通常不是我們?cè)噲D增加的使用量。

運(yùn)行模型的某些部分受計(jì)算限制,這意味著性能瓶頸在于 GPU 計(jì)算值的速度。一個(gè)受計(jì)算限制的過(guò)程是 LLM 的預(yù)填充階段,在此階段,模型處理完整提示以創(chuàng)建其響應(yīng)的第一個(gè)標(biāo)記。

但LLM 推理的大部分內(nèi)容都受內(nèi)存限制。在第一個(gè) token 之后,LLM 的大部分生成過(guò)程都受內(nèi)存限制,這意味著 GPU 的 VRAM 上的帶寬是限制 token(或圖像、轉(zhuǎn)錄、音頻文件等)生成速度的因素。

鑒于大多數(shù) LLM 推理都受到內(nèi)存?zhèn)鬏斚拗疲覀儗ふ以黾佑?jì)算利用率的策略,以便我們可以對(duì)訪問(wèn)的每個(gè)字節(jié)內(nèi)存運(yùn)行更多計(jì)算。

二、如何提高 GPU 利用率

通常,您可以通過(guò)在推理期間增加批處理大小來(lái)提高 GPU 利用率。批處理大小決定了 LLM 中同時(shí)處理的用戶輸入數(shù)量。更大的批處理大小可以讓模型使用更多的計(jì)算資源,即使在內(nèi)存受限的情況下也是如此。從 VRAM 讀取的每個(gè)模型權(quán)重都會(huì)同時(shí)應(yīng)用于更多輸出,從而增加每字節(jié)帶寬可以使用的計(jì)算量。

增加批處理大小可以提高吞吐量,吞吐量是衡量 GPU 實(shí)例每秒可以處理多少請(qǐng)求的指標(biāo)。但是,增加吞吐量通常會(huì)使延遲變得更糟,這意味著用戶必須等待更長(zhǎng)時(shí)間才能獲得模型輸出。在嘗試最大化利用率時(shí),管理這種權(quán)衡很重要。

一旦多個(gè)實(shí)例的利用率都很高,就值得考慮切換到更強(qiáng)大的 GPU 類型。例如,從 A100 切換到 H100可以節(jié)省 20-45% 的工作負(fù)載,這些工作負(fù)載的利用率很高,流量足以需要多個(gè) A100 GPU。

擴(kuò)展我們的拼車比喻,切換到 H100 就像為您的 12 人團(tuán)體叫一輛 Uber XL 車——一輛車有 6 名乘客,您只需要兩輛車,這樣即使 XL 的車費(fèi)稍微貴一些,也能節(jié)省更多錢(qián)。

三、如何跟蹤 GPU 利用率

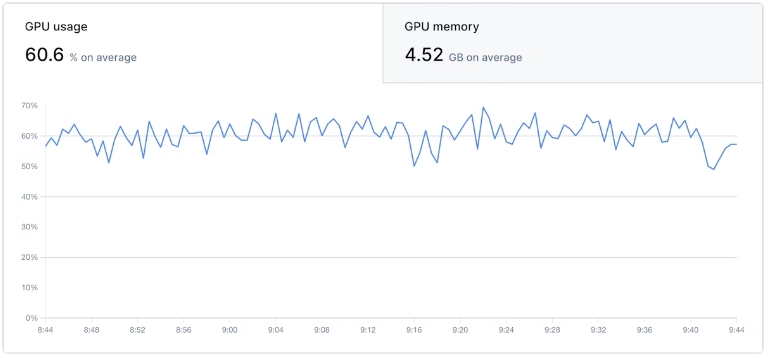

在工作區(qū)中,您可以查看每個(gè)部署模型的計(jì)算和 VRAM 容量(而非帶寬)的 GPU 利用率。這些圖表按時(shí)間戳與流量和自動(dòng)縮放圖表對(duì)齊,因此您可以準(zhǔn)確地看到實(shí)際使用情況如何影響利用率。

在調(diào)整模型優(yōu)化和批量大小時(shí),使用這些指標(biāo)來(lái)查看每個(gè)更改對(duì) GPU 利用率的影響。