我們在捷智算平臺上收到的最常見問題之一是如何充分利用我的 GPU?今天針對這個問題,為大家做一個詳細的解答,同時分享給大家合適的 GPU 選擇指南。

最重要的因素

首先,你需要有足夠的 VRAM 來適應你的模型。這應該是你首先要考慮的。

Tensor Core 用于矩陣乘法,這對于任何 AI 應用都至關重要。從 2017 年的 V100 開始,專業 GPU 中引入了 Tensor Core,2018 年的 GeForce 20 系列也引入了消費級 GPU。捷智算平臺上的絕大多數 GPU 都配有 Tensor Core,那么問題就在于有多少個呢?

事實上,不是。Tensor Core 非常快 - 快到大多數時候都沒有得到充分利用,具體取決于批處理大小。因此,瓶頸通常是帶寬,包括內存和互連(GPU 之間)。

FP16 與 FP8

FP8 用 8 位表示數字,而不是之前標準的 FP16 的 16 位。最新的 GPU(例如 H100 和即將推出的 B100)支持針對 FP8 的優化。

精度較低時,模型可以使用較低的 VRAM 和帶寬運行,因此計算量也較少。但是,您必須小心,不要顯著降低模型性能。如果您已經測試過可以從 FP8 中受益,或者有理由認為可以受益,請確保您使用的是支持 FP8 的 GPU。

最佳推理精選

消費級顯卡的性價比通常更高,因為企業級 GPU 的標價明顯更高。大多數云提供商不提供消費級 GPU,但捷智算平臺提供。

如果您可以將模型裝入 24 GB VRAM 卡中,那么 3090 和 4090 的推理價值將非常高。超過 24 GB,您將被迫進入企業領域,而價值卻無法接近。如果您尚未確定特定模型,那么將其裝入 24 GB VRAM 卡中將大大降低您的推理成本。

除此之外,下一個價值等級是較低級別的企業卡,例如 V100 32 GB、A6000(48 GB)、L40(48 GB)和 6000 Ada(48 GB)。

然后,你終于有了 A100 80 GB 和 H100。如果你需要這么高的性能來進行推理,你肯定會知道的。總的來說,A100 提供了更好的推理價值,而 H100 最適合訓練。

企業 GPU

1、擴展計算:NVLink 和 InfiniBand

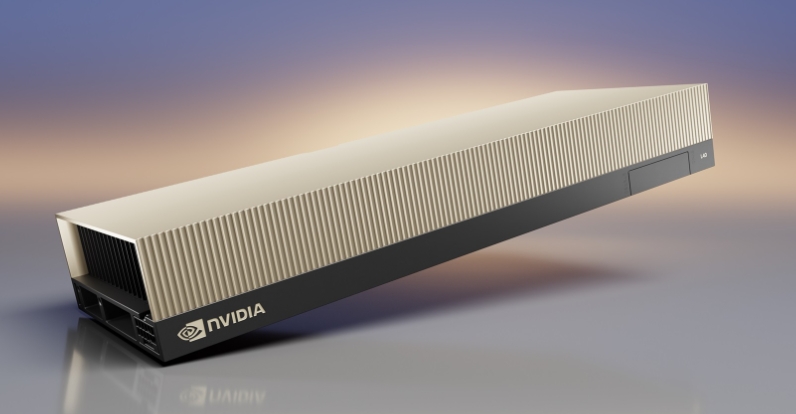

搭載 NVLink 的 NVIDIA A100

由于 GPU 必須互連且受帶寬限制,因此將服務器從 1 個 GPU 擴展到 8 個 GPU 并不會自動實現 8 倍性能。現代 GPU 支持更快的互連,因此對于 V100 等較舊的 GPU,這種下降會更加明顯。

在捷智算平臺上,如果您租用 2x、4x 或 8x H100/A100 服務器,您的 VM 會在可用時自動通過 NVLink 互連。

NVLink 連接服務器內的 GPU,而 InfiniBand 連接多臺服務器。預計 InfiniBand 的價格會略有上漲,約為 5-10%。請記住,除非您正在訓練非常大的模型,否則這并不是必需的。

對于推理,我們已經看到,運行每個虛擬機 4 個 GPU 且每個 8xH100 節點運行兩個實例的開源模型可獲得最佳性能,優于運行 2 個 GPU 或 8 個 GPU 的模型。此外,我們已經看到,使用 Triton 推理的 TensorRT-LLM 的吞吐量大約是 vLLM 的兩倍。

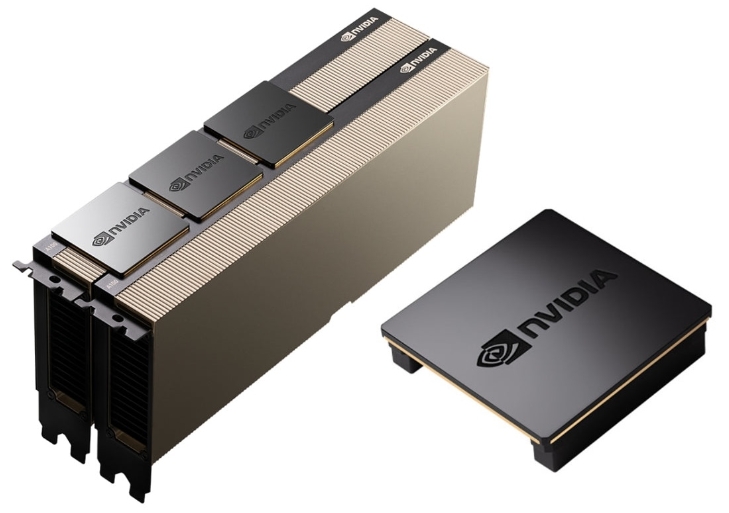

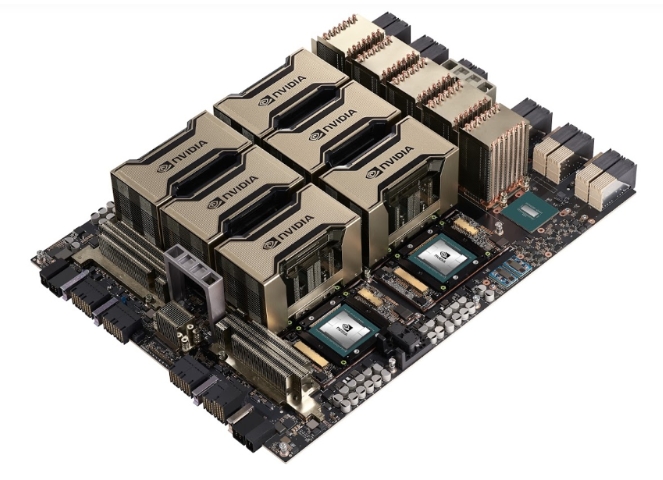

2、SXM 與 PCIe(僅限 H100、A100 和 V100)

NVIDIA A100 SXM4 服務器

SXM 是 NVIDIA 專有的外形尺寸,可提高電力輸送、冷卻和帶寬。僅提供 PCIe 的云提供商通常不會指定他們的 H100 是 SXM 還是 PCIe。這是因為 PCIe 的性能要低得多,最多低 25%!這是因為 H100 PCIe 的內存帶寬僅為 2 TB/s,而 SXM5 的內存帶寬為 3.35 TB/s。總體而言,SXM 將 GPU 緊密地集成在服務器中,因此它們可以有效地作為單個超大 GPU 運行。對于 A100 和 V100,性能上沒有太大差別,所以只要選擇更便宜的就行。