在當今快速發展的人工智能領域,部署大型語言模型以滿足各種推理需求變得至關重要。近期,NVIDIA H200 Tensor Core GPU 的推出引起了廣泛關注,展示了一項關鍵的進步。本文將對這款GPU以及之前發布的NVIDIA H100 和L40S進行深度比較,通過對它們的性能進行評估,更好地了解它們在不同應用場景下的表現,從而幫助我們更好地選擇GPU。

一、NVIDIA H200 概述

NVIDIA H200 開創了 GPU 技術的新時代,旨在通過無與倫比的性能和內存能力顯著提升 AI 和 HPC 工作負載。

H200 基于 NVIDIA Hopper 架構構建,配備 141GB HBM3e 內存和 4.8TB/s 內存帶寬,較其前代 H100 有了實質性的飛躍,增強了生成式 AI 和科學計算能力,同時提高了能源效率并降低了擁有成本。

1、預計表現

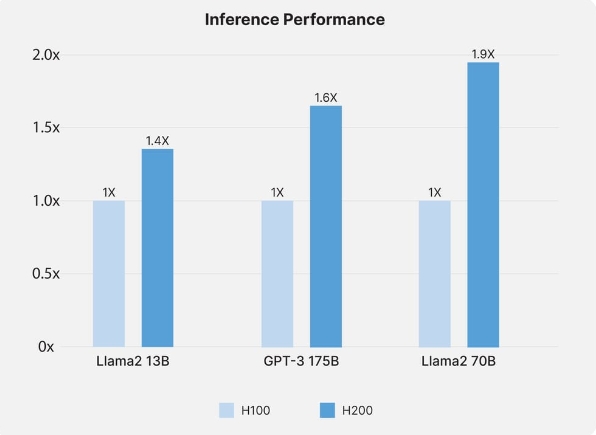

該 GPU 有望重新定義性能標準,使 H100 對 Llama2 70B 等大型語言模型的推理性能提高一倍,有望對 AI 模型訓練和推理任務產生變革性影響。

推理性能來源:NVIDIA

2、H200 推理性能

NVIDIA H200 為 AI 推理樹立了新標準,尤其在處理 Llama2 70B 等大型語言模型方面表現突出。與 H100 相比,H200 的推理性能提高了一倍,有助于快速處理和分析,這對于依賴實時數據解釋的應用程序至關重要。這種增強的功能使企業能夠高效部署更復雜的 AI 模型,從而顯著提高 AI 驅動解決方案的響應時間和準確性。

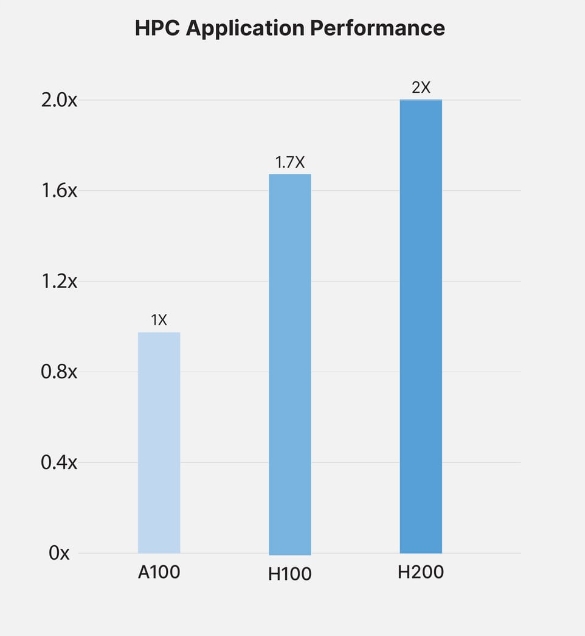

HPC 應用程序性能來源:NVIDIA

3、HPC 性能

在高性能計算領域,H200 憑借顯著的內存帶寬和處理能力改進脫穎而出。GPU 架構配備 141GB HBM3e 內存和 4.8TB/s 帶寬,確保在內存密集型 HPC 應用中提供無與倫比的性能。這些進步加快了數據傳輸速率并減少了復雜計算中的瓶頸,使研究人員和工程師能夠在模擬、科學研究和人工智能任務中更快地獲得結果。

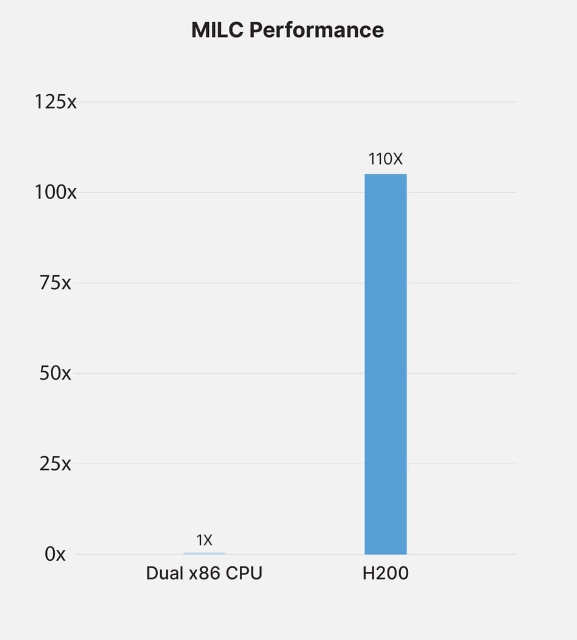

MILC 性能來源:NVIDIA

4、MILC 性能

對于 MIMD 格點計算 (MILC),即量子色動力學 (QCD) 模擬中的關鍵組件,H200 GPU 提供了顯著的性能提升。利用其卓越的內存帶寬和計算效率,H200 顯著加快了 MILC 數據集的處理速度。這種加速對于推進我們對量子現象的理解和促進粒子物理研究的突破至關重要。H200 的功能確保可以更有效地訪問和操作數據,與前幾代 GPU 相比,性能指標呈指數級增長,從而大大加快了這一專業領域的洞察時間。

5、未來用例

實現先進的人工智能研究和開發

促進更復雜和更大規模的模型訓練

推動科學計算和發現的突破

二、NVIDIA H100 概述

作為NVIDIA在AI和HPC領域的旗艦產品,H100 GPU體現了加速AI模型和管理大數據集的技術巔峰,在數據中心和研究領域得到廣泛認可。

H100 先進的架構和內存功能使其能夠靈活應對復雜的 AI 和 HPC 挑戰,從而提供顯著的計算和模型訓練效率。

1、表現

H100 在 AI 訓練和推理方面表現出色,有助于加快數據處理和模型迭代,這對于高風險應用至關重要。

2、用例

深度學習計劃和項目

跨學科的科學模擬

企業和研究環境中的大規模人工智能部署

三、NVIDIA L40s 概述

NVIDIA L40S 專為專業可視化和 AI 推理而設計,采用 Ada Lovelace 架構,是一款適用于創意和設計導向任務的多功能 GPU。

L40S 擅長處理密集的圖形工作負載和 AI 驅動的應用程序,提供強大的計算能力和圖形性能組合,滿足廣泛的專業需求。

1、表現

L40S 表現出了渲染和人工智能驅動設計的效率,其性能凸顯了其在需要圖形和計算能力的應用程序中多功能性和實用性。

2、用例

虛擬設計和沉浸式環境

內容創作和多媒體項目

復雜的 3D 建模和動畫

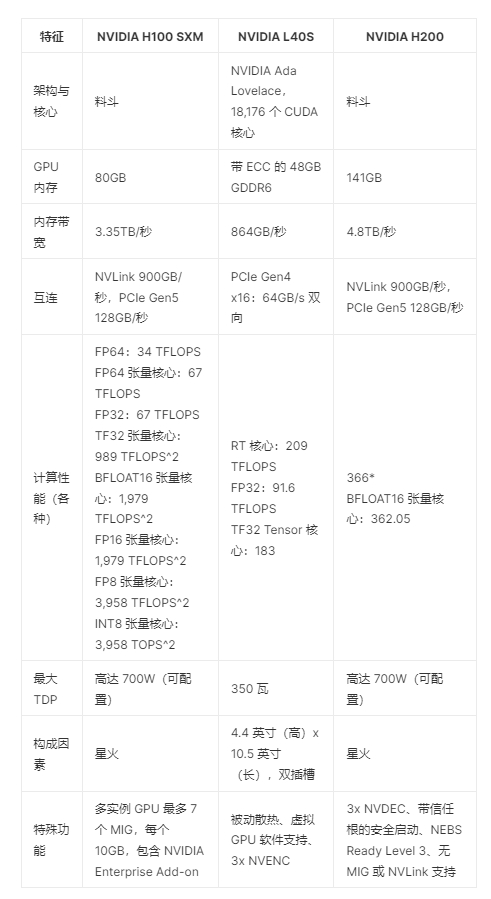

四、NVIDIA H200、H100 和 L40S規格比較

綜上所述,通過對NVIDIA H200、NVIDIA H100和NVIDIA L40S的性能進行比較,我們可以清楚地看到它們在推理任務中的表現差異。從 H200 在 AI 和 HPC 方面的革命性功能、H100 在類似領域的性能,到 L40S 在可視化和 AI 推理方面的專業化,捷易科技將這些 GPU 集成在一起,開發出重新定義 IT 基礎設施和 AI 應用程序功能的解決方案。