NVIDIA 在人工智能 (AI) 和高性能計(jì)算 (HPC) 領(lǐng)域的最新創(chuàng)新是 NVIDIA H200 Tensor Core GPU,它是廣受歡迎的 NVIDIA H100的繼任者。NVIDIA H100 在過(guò)去一年中一直是 AI 應(yīng)用程序的首選,以其在 AI 訓(xùn)練和推理所需的并行處理方面的出色性能和效率而聞名。隨著企業(yè)不斷尋求技術(shù)進(jìn)步,內(nèi)存容量和帶寬均顯著提升的H200將成為 GPU 技術(shù)的新標(biāo)桿。

一、NVIDIA H200 概述

1、首款采用 HBM3e 內(nèi)存的 GPU,提供 141 GB 容量,速度達(dá) 4.8 TB/s

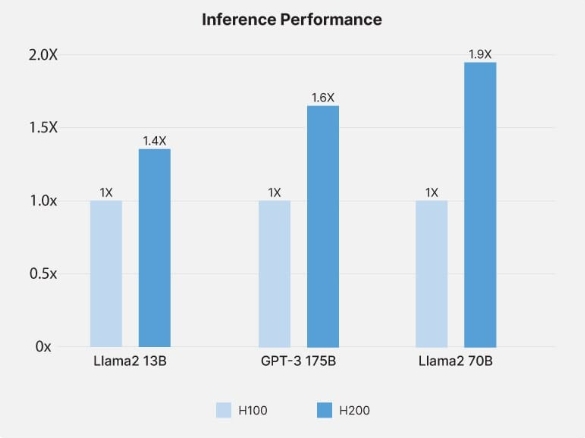

2、GPT-3 175B 推理性能提高 1.6 倍,特定 HPC 應(yīng)用性能提高 110 倍。

3、提高能源效率并降低總擁有成本 (TCO)

4、大型語(yǔ)言模型(如 Llama2)的推理速度提高 2 倍

二、NVIDIA H200 相對(duì)于H100的主要改進(jìn)

NVIDIA H100 與 NVIDIA H200 的推理性能

NVIDIA H200 相較 NVIDIA H100 有顯著的進(jìn)步,主要體現(xiàn)在內(nèi)存容量和帶寬方面。它是首款集成 141GB HBM3e 內(nèi)存的 GPU,可提供驚人的 4.8TB/s 帶寬。這種增強(qiáng)不僅意味著更大的存儲(chǔ)空間,還意味著能夠以前所未有的速度處理和傳輸數(shù)據(jù)。這種能力對(duì)于處理現(xiàn)代 AI 模型和 HPC 任務(wù)的大量數(shù)據(jù)需求至關(guān)重要,因?yàn)榭焖僭L(fǎng)問(wèn)大型數(shù)據(jù)集至關(guān)重要。

性能方面,NVIDIA H200 明顯優(yōu)于其前代產(chǎn)品,Llama2 70B 的推理速度提高了 1.9 倍,GPT-3 175B 的推理速度提高了 1.6 倍。

對(duì)于 HPC 應(yīng)用,NVIDIA H200 提供了額外的改進(jìn),其 HPC 應(yīng)用性能比傳統(tǒng)基于 CPU 的解決方案快 110 倍,性能比前幾代產(chǎn)品提高 2 倍。速度和效率的提升并不以更高的能耗為代價(jià)。事實(shí)上,NVIDIA H200 保持了能源效率和成本效益,符合人們對(duì)可持續(xù)和經(jīng)濟(jì)計(jì)算解決方案日益增長(zhǎng)的重視。

三、對(duì)人工智能和高性能計(jì)算的影響

NVIDIA H200 增強(qiáng)的內(nèi)存和速度對(duì) AI 應(yīng)用,尤其是大型語(yǔ)言模型 (LLM) 產(chǎn)生了重大影響。141GB HBM3e 內(nèi)存和 4.8TB/s 帶寬有助于更快地處理復(fù)雜數(shù)據(jù)集,這對(duì)于訓(xùn)練和運(yùn)行 GPT-3 或 Llama2 等復(fù)雜的 AI 模型至關(guān)重要。此功能可以更有效地處理這些模型所需的大量數(shù)據(jù),從而縮短訓(xùn)練時(shí)間并提高結(jié)果的準(zhǔn)確性。更快的處理速度還可以實(shí)現(xiàn)實(shí)時(shí)分析和決策,這對(duì)于自動(dòng)駕駛汽車(chē)和先進(jìn)機(jī)器人等 AI 驅(qū)動(dòng)的應(yīng)用至關(guān)重要。

在高性能計(jì)算 (HPC) 領(lǐng)域,NVIDIA H200 的進(jìn)步加速了各種應(yīng)用。例如,在科學(xué)研究和模擬中,GPU 快速處理大型數(shù)據(jù)集的能力可以顯著減少?gòu)?fù)雜計(jì)算所需的時(shí)間。這種速度在氣候建模、基因組測(cè)序和物理模擬等領(lǐng)域至關(guān)重要,因?yàn)檫@些領(lǐng)域需要快速分析大量數(shù)據(jù)。通過(guò)實(shí)現(xiàn)更快、更高效的數(shù)據(jù)處理,NVIDIA H200 可幫助研究人員更快地獲得結(jié)果,促進(jìn)各個(gè)科學(xué)領(lǐng)域的突破。

NVIDIA H200 的另一個(gè)優(yōu)勢(shì)是其專(zhuān)注于可持續(xù)計(jì)算。盡管性能有所提升,但 GPU 仍保持了能源效率,滿(mǎn)足了日益增長(zhǎng)的環(huán)保技術(shù)解決方案需求。這一方面對(duì)于大型計(jì)算設(shè)施尤其重要,因?yàn)槟茉聪暮蜔崃慨a(chǎn)生是主要問(wèn)題。NVIDIA H200 的節(jié)能設(shè)計(jì)有助于減少計(jì)算操作的總體碳足跡,使其成為面向未來(lái)的組織的負(fù)責(zé)任選擇。

四、捷易科技在NVIDIA H200 GPU中的作用

在捷易科技,我們專(zhuān)注于設(shè)計(jì)充分利用最新技術(shù)(如 NVIDIA H200 GPU)的定制 IT 基礎(chǔ)設(shè)施。我們的解決方案專(zhuān)為滿(mǎn)足 AI 的特定需求而量身定制,確保充分利用 NVIDIA H200 的功能。我們了解每個(gè)客戶(hù)的需求都是獨(dú)一無(wú)二的,因此我們針對(duì)您的特定應(yīng)用設(shè)計(jì)系統(tǒng)計(jì)算能力、內(nèi)存和存儲(chǔ)。

總而言之,NVIDIA H200代表著GPU技術(shù)的最新進(jìn)展,其引入了一系列突破性特性和創(chuàng)新,為人工智能和高性能計(jì)算帶來(lái)了巨大的可能性。通過(guò)深入了解NVIDIA H200的架構(gòu)、性能和應(yīng)用前景,我們可以清晰地看到,這一技術(shù)將在未來(lái)的計(jì)算領(lǐng)域發(fā)揮著舉足輕重的作用。