機器學習 (ML)正在改變各行各業,它能夠開發復雜的模型來分析大量數據并做出準確的預測。TensorFlow是一種流行的開源 ML 框架,已成為研究人員和開發人員的強大工具。

TensorFlow 利用圖形處理單元 (GPU)的計算能力來加速深度學習模型的訓練和推理過程。如前所述,GPU 擅長并行處理,使其成為處理 ML 任務所需的密集計算的理想選擇。領先的 GPU 制造商 NVIDIA 提供了一系列專為機器學習工作負載設計的高性能選項。

在本文中,我們將比較 NVIDIA A4000 和 A5000 GPU。兩者都是NVIDIA 安培架構的一部分,與前幾代相比,該架構提供了顯著的性能改進。我們的比較將評估它們在運行 TensorFlow 時的性能,并深入了解哪種 GPU 在各種機器學習任務中表現更好。

為什么使用 GPU 來完成機器學習任務?

我們已經廣泛討論了 GPU 如何通過并行處理能力徹底改變機器學習和深度學習。憑借數千個核心,GPU 可以滿足大規模機器學習算法的計算需求,從而實現更快的訓練、更快的模型開發以及高效處理復雜計算。

GPU 專為處理機器學習中常見的矩陣乘法和浮點計算而設計,非常適合數據密集型任務。通過利用 GPU,研究人員和開發人員可以管理海量數據集并加速訓練和推理過程,最終推動機器學習領域的發展。

什么是 TensorFlow?

TensorFlow 是一個廣泛使用的開源機器學習框架,受到研究人員、開發人員和行業專業人士的青睞。它為構建、訓練和部署各種機器學習模型(包括神經網絡)提供了一個全面的生態系統。

TensorFlow 的底層實現是使用多維數組(稱為張量)來定義和操作數學運算。這些張量在計算圖中移動,其中節點表示運算,邊表示數據依賴關系。這種基于圖的方法可以實現高效的并行計算,使 TensorFlow 成為大規模數據處理和復雜數學運算的理想選擇。

TensorFlow 具有高級 API,可簡化機器學習模型的創建和訓練。用戶可以從各種預構建的層、激活函數和優化算法中進行選擇,也可以創建自定義組件以滿足其特定需求。此外,TensorFlow 支持多種數據格式,并與其他流行庫(如NumPy和Pandas)無縫集成,從而方便將其納入現有工作流程。

TensorFlow 的一個顯著優勢是它能夠利用 GPU 來加速機器學習任務。它與 NVIDIA GPU 的兼容性尤其值得注意。NVIDIA 提供了 GPU 加速庫,如計算統一設備架構 (CUDA)和CUDA 深度神經網絡 (cuDNN),TensorFlow 使用這些庫在 NVIDIA GPU 上高效執行計算。

CUDA是一個并行計算平臺和 API,可讓開發人員充分利用 NVIDIA GPU。得益于其大規模并行架構,TensorFlow 使用 CUDA 將計算密集型操作卸載到 GPU。這種 GPU 加速大大加快了訓練和推理過程,從而加快了模型開發和部署速度。

另一方面,cuDNN是一個專為深度神經網絡設計的 GPU 加速庫。它提供了卷積和池化等基本操作的高度優化實現,使 TensorFlow 在 NVIDIA GPU 上運行時能夠實現更高的性能。

通過 CUDA 和 cuDNN 利用 GPU,TensorFlow 可幫助機器學習從業者訓練更復雜的模型、處理更大的數據集并更快地獲得結果。此功能確保 TensorFlow 始終處于先進機器學習研究和開發的前沿。

NVIDIA A4000 和 A5000 的規格

NVIDIA A4000 和 A5000 GPU 屬于 Ampere 架構的一部分,與前幾代產品相比,性能顯著提升。這些 GPU 專為滿足機器學習任務(包括使用 TensorFlow 的任務)的苛刻要求而量身定制。

以下是與機器學習相關的關鍵技術規格:

NVIDIA A4000:

內存帶寬:高達 512 GB/s

CUDA 核心數: 6144

張量核心: 192

最大功耗: 140W

內存大小: 16GB GDDR6

NVIDIA A5000:

內存帶寬:高達 768 GB/s

CUDA 核心數: 8192

張量核心: 256

最大功耗: 230W

內存大小: 24GB GDDR6

兩款 GPU 都具有大量內存帶寬,這對于高效地將數據傳送到計算核心至關重要。A5000 擁有更多 CUDA 核心,可以同時管理更多并行任務,從而可能縮短訓練和推理時間。此外,兩款 GPU 中的張量核心都有助于加速混合精度運算,這在深度學習中很常用。

TensorFlow 中 A4000 與 A5000 的比較分析

與 NVIDIA A4000 相比,A5000 提供更多 CUDA 核心、更大的內存容量和更高的內存帶寬。這些增強的規格使 A5000 成為更密集的計算任務的理想選擇,特別是在 AI 研究、數據科學和高級設計可視化領域。以下是主要區別:

架構和制造工藝:這兩款 GPU 均基于 Ampere 架構,這增強了它們有效處理并行處理和復雜圖形和 AI 計算的能力。

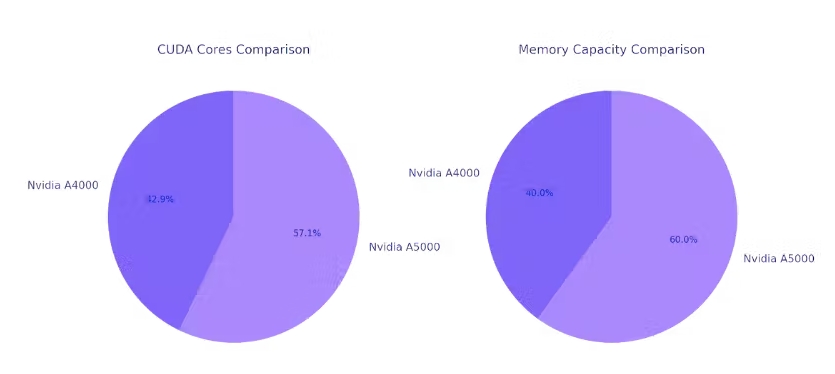

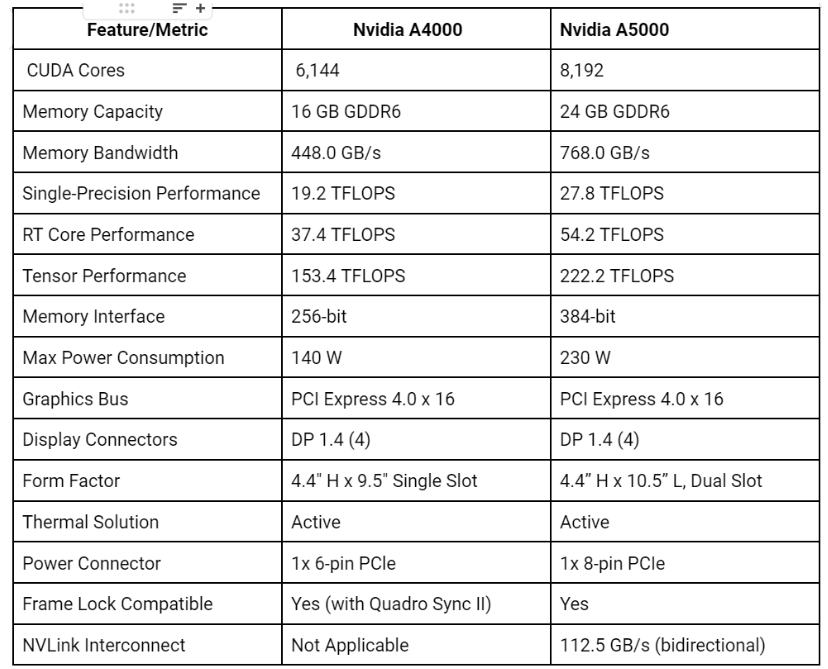

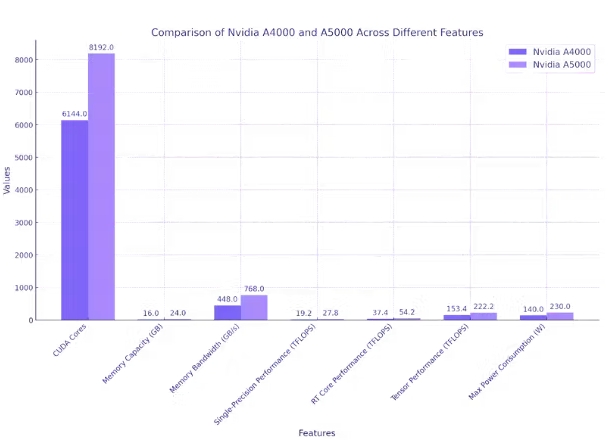

性能核心: A5000 具有更多 CUDA 核心(8,192 個 vs. 6,144 個),這對于并行處理和加速計算任務至關重要。核心數量的增加可以帶來更好的性能。

內存:與 A4000 的 16 GB 相比,A5000 提供更大的 24 GB GDDR6 內存容量。此外,A5000 的內存帶寬更高,為 768 GB/s,而 A4000 為 448 GB/s。這使得 A5000 能夠管理更大的數據集并實現更快的數據傳輸速率。

功耗: A5000 的功耗率為 230 W,高于 A4000 的 140 W。這種增加的功耗可能需要更強大的冷卻解決方案,對于系統構建者來說,這是一個重要的考慮因素。

目標應用:雖然這兩種 GPU 都是為專業環境中的高性能計算而設計的,但 A5000 擁有更大的 CUDA 核心數量、更大的內存容量和更高的內存帶寬,使其更適合執行要求苛刻的任務和處理更大的數據集。

基準和性能指標

在比較用于 TensorFlow 任務的 GPU 時,幾個性能指標至關重要:

處理速度: GPU 執行計算的速度對于減少訓練和推理時間至關重要。具有更多 CUDA 核心和更高時鐘速度的 GPU 通常可提供更快的處理速度。

內存利用率: GPU 的內存帶寬和容量對于高效處理大型數據集至關重要。更高的內存帶寬可以加快與 GPU 之間的數據傳輸速度,而更大的內存容量則可以處理更廣泛的模型和數據集。

電源效率:功耗是一個重要因素,特別是對于大型機器學習項目而言。提供高性能同時最大限度降低功耗的 GPU 可以節省成本并帶來環境效益。

這些指標共同影響 TensorFlow 任務的整體性能和有效性,包括訓練神經網絡、數據處理速度和模型準確性。

以下是 A4000 和 A5000 的一些關鍵性能基準:

NVIDIA A4000 和 A5000 GPU 為 TensorFlow 任務提供了強大的計算能力,其中 A5000 在大多數指標上的表現通常優于 A4000。這兩款 GPU 都具有大量 CUDA 核心,這些核心是并行處理器,可大大加速計算任務。不過,A5000 的數量為 8192,而 A4000 的數量為 6144。

在內存容量方面,A5000 的 24 GB GDDR6 超過了 A4000 的 16 GB,使其能夠在 GPU 內存中容納更多數據,這對于大規模 TensorFlow 任務尤其有利。

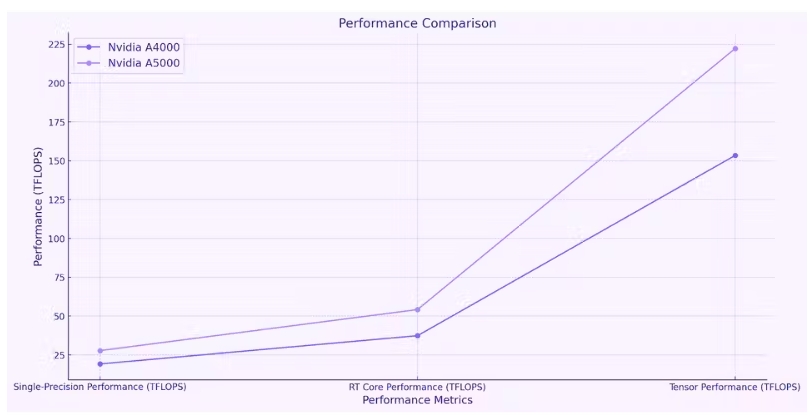

內存帶寬(衡量從 GPU 內存讀取或寫入數據的速度)在 A5000(768 GB/s)中也高于 A4000(448 GB/s)。就單精度性能(衡量 GPU 執行浮點計算的速度)而言,A5000 的表現優于 A4000,提供 27.8 TFLOPS,而 A4000 為 19.2 TFLOPS。

與 A4000(37.4 TFLOPS)相比,A5000 還具有卓越的 RT Core 性能(54.2 TFLOPS),表明光線追蹤能力更佳。

張量性能(衡量張量運算效率)是 A5000 的另一個出色領域。它提供 222.2 TFLOPS,明顯高于 A4000 的 153.4 TFLOPS。A5000 確實消耗更多電量,最大消耗為 230 W,而 A4000 為 140 W。

兩款 GPU 均配備四個 DP 1.4 顯示連接器,但 A5000 的外形尺寸更大,需要更強大的電源連接器(1 個 8 針 PCIe,而 A4000 為 1 個 6 針 PCIe)。雖然兩款 GPU 都兼容幀鎖,但只有 A5000 支持 NVLink Interconnect,提供 112.5 GB/s(雙向)的速度。

總體而言,這兩款 GPU 都非常適合 TensorFlow 任務,但 A5000 在多個指標上通常都表現優異。然而,這種增強的性能是以更高的功耗為代價的。

關于 A4000 和 A5000 用于機器學習的最終想法

由于規格不同,NVIDIA A4000 和 A5000 GPU 的 TensorFlow 性能也有所不同。A5000 擁有更多 CUDA 核心和更大內存,在需要大量并行處理和大數據集處理的任務(例如訓練復雜的深度學習模型)中表現出色。相比之下,由于功耗較低,A4000 對于要求不高的任務效率更高。對于大型數據集,A5000 的更大內存和更高帶寬可以縮短計算時間,而這兩種 GPU 都可以為較小的數據集提供令人滿意的性能。

因此,兩者之間的選擇取決于任務的具體要求。

為 TensorFlow 項目選擇合適的 GPU 需要考慮性能、成本效益、能耗、使用壽命和可擴展性。通過評估這些因素并了解 GPU 技術和 TensorFlow 的進展,數據科學家和 ML 工程師可以做出明智的決策,以優化他們的機器學習工作流程并實現他們的項目目標。